הערות המכון בנושא הנחיית הרשות להגנת הפרטיות בנושא מערכות AI

בהמשך לדיונים אלו, הגיש המכון לרשות להגנת הפרטיות הערות מקצועיות לטיוטת ההנחיה שפורסמה בנושא, תוך מיקוד בהיבטים הטכנולוגיים המעשיים של הגנת פרטיות במערכות בינה מלאכותית. בין הנקודות שציין המכון: המכון […]

כנס של המכון הישראלי למדיניות טכנולוגיה במסגרת שבוע הסייבר - רגולציית בינה מלאכותית בעולם ופרטיות בעידן של קונפליקט.

Event Recap: On June 26, 2024, FPF – Israel held a Cyber Week Conference on: From AI Regulation Around the Globe to Data Protection in Time of Conflict Background: Once […]

Co-host event: DEVELOPMENTS IN GLOBAL LEGISLATION

We are excited to invite you to a co-host event by Shibolet Law Firm, Networking Advertising Initiative (NAI), FPF – Israel Tech Policy Institute on: ‘Developments in Global Legislation – […]

וובינר בנושא: מערכות לזיהוי פנים בשימוש מערכת האכיפה

בוובינר בין שעה שנערך ב-6 בנובמבר 2022 עסקנו בנושא “מערכות לזיהוי פנים בשימוש מערכת האכיפה“. בוובינר השתתפו שלוש דוברות: עו”ד נעמה בן צבי ראש מרכז פיקוח והכוונה, היחידה להזדהות ויישומים ביומטריים, […]

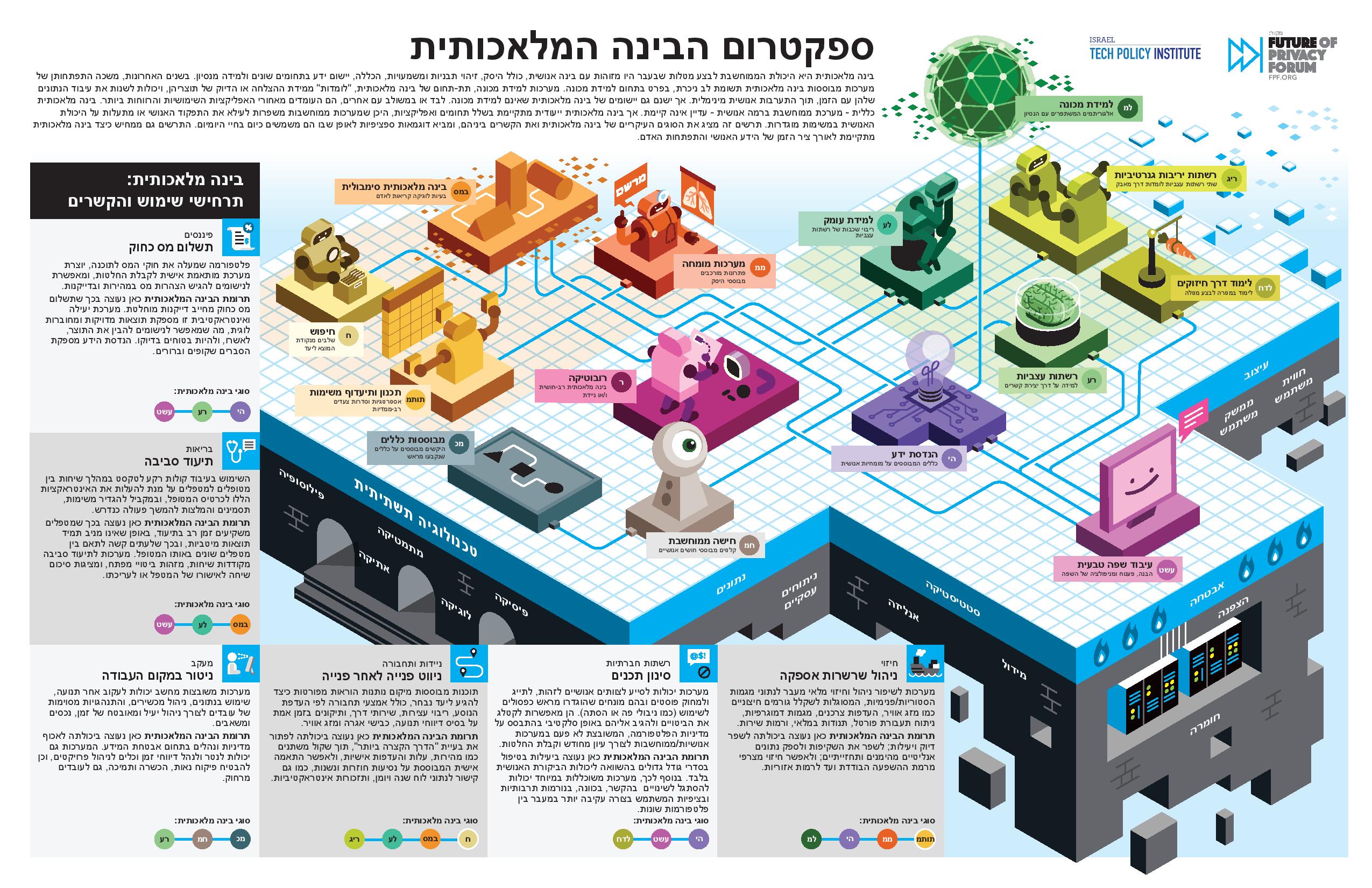

ספקטרום הבינה המלאכותית

מדריך חזותי למגוון טכנולוגיות הבינה המלאכותית בינה מלאכותית היא היכולת הממוחשבת לבצע מטלות שבעבר היו מזוהות עם בינה אנושית, כולל היסק, זיהוי תבניות ומשמעויות, הכללה, יישום ידע בתחומים שונים ולמידה […]

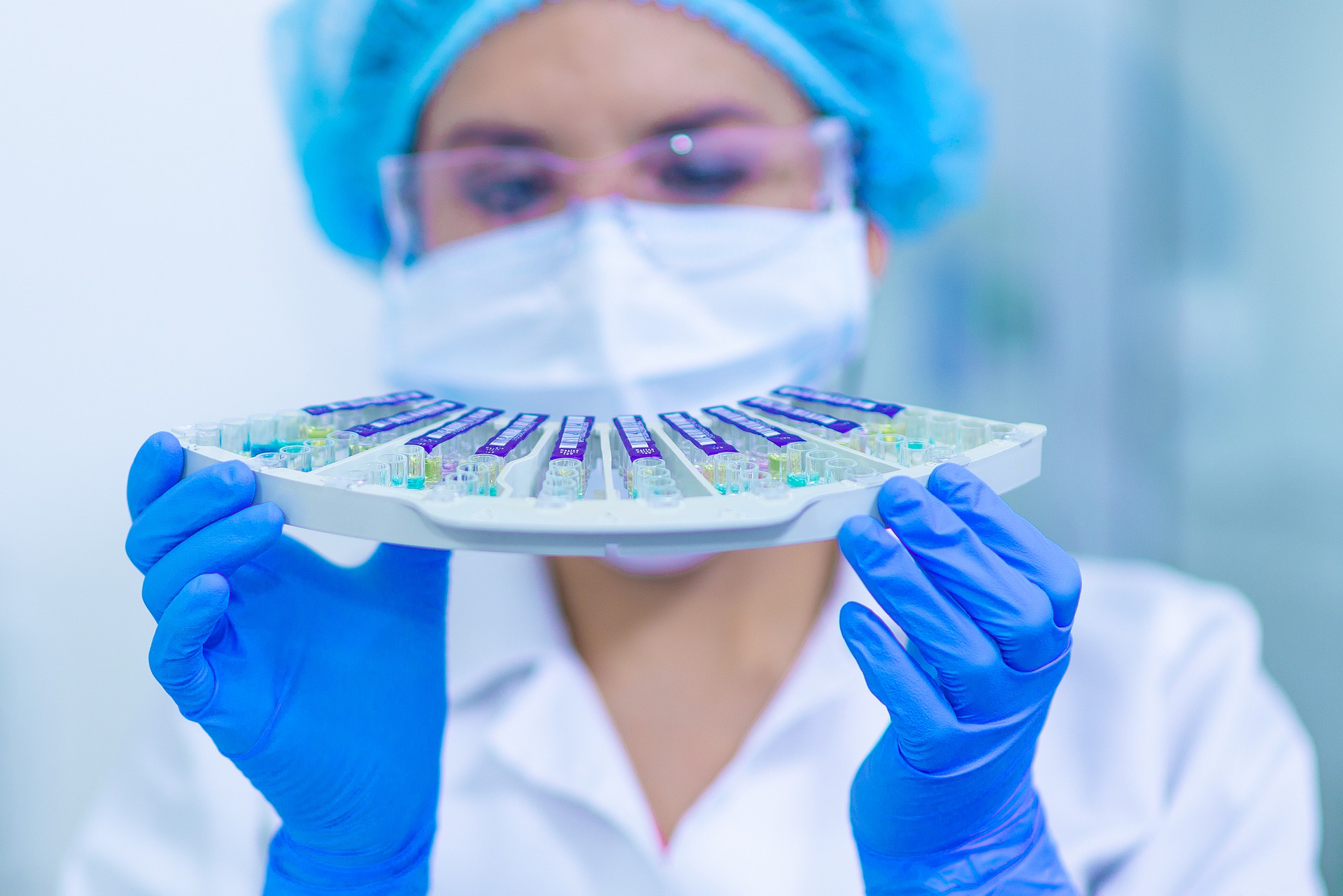

בינה מלאכותית בהפריה חוץ-גופית (AI in IVF) – קליניקה, מעבדה, טכנולוגיה ואתיקה

הוובינר שקיימנו לאחרונה 'בינה מלאכותית בהפריה חוץ-גופית (AI in IVF) – קליניקה, מעבדה, טכנולוגיה ואתיקה', דן בהיבטים הבאים של היישום החדשני של טכנולוגיית AI ב – IVF, למטרת בחירה אופטימלית של עוברים להחזרה לרחם.

בינה מלאכותית בשירותי ממשל – נקודות מבט: משפט, אתיקה, רווחה וטכנולוגיה

כנס בינה מלאכותית בשירותי ממשל – נקודות מבט: משפט, אתיקה, רווחה וטכנולוגיה ביום 26.1.21 קיים המכון הישראלי למדיניות טכנולוגיה, בשיתוף המעבדה למשפט מדעי המידע ואתיקה דיגיטלית שבפקולטה למשפטים […]

בינה מלאכותית בשירותי ממשל – הטמעת מערכות לקבלת החלטות מבוססות-אלגוריתם בשירותי הרווחה

מערכת הרווחה קלטה לשורותיה לאחרונה עובדת סוציאלית חדשה, בשם בינה.